站长学院

CMS建站教程 SEO优化攻略

来源:齐鲁建站 栏目:排名优化 阅读: 日期:2020-10-08

robots对于网站的抓取起到非常重要的作用,robots看似一个非常简单的操作,但平时如果没有太注意或多操作,你写的robots未必就是正确的,因为里面涉及到一些指令,没有写对可能会影响网站的抓取。今天齐鲁建站小编就来说说如何制作一份标准的网站robots txt文件。

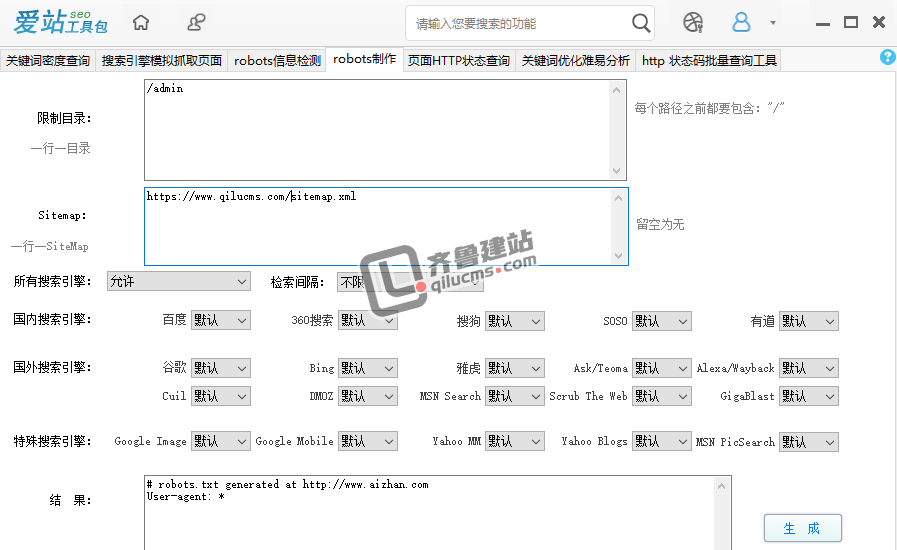

1、小编建议大家使用爱站的robots制作工具

根据你的需要来更改为自己的网站和网站地图的格式,如果不禁止蜘蛛爬行就默认允许,如图

2、更改完之后,就生产代码,并创建记事本,命名为robots.txt,复制代码保存即可

注意事项:

生成的有效代码如下:

User-agent: *

Disallow:

Sitemap: http://www.qilucms.com/sitemap.xml

其中,

①“User-agent: *”的通配符"*"代表所有机器人,

②“Disallow: ”代表不禁止蜘蛛抓取页面,千万别写成“Disallow: /”,差个“/”就是代表禁止抓取所有页面,

③Sitemap: http://www.qilucms.com/sitemap.xml:就是网站地图的地址,引导蜘蛛爬行你的网站地图